責任あるAI(レスポンシブAI)とは?AI倫理やAIガバナンス、説明可能なAIとの違いまで解説

INDEX

皆さんは責任あるAIをご存じですか?多くの企業がAI開発に挑む中で、AIに全力で傾倒していく風潮に危機感を抱く人たちが少なくありません。今回は責任あるAIとはどういうものかをご紹介します。

本記事では責任あるAIを中心に、その基本原則やAIガバナンスとの違いなども合わせて解説していきます。

責任あるAIとは?

責任あるAIとはどのようなものなのか、基本的な情報をご紹介していきます。

責任あるAIの概要

責任あるAIは、開発したAIが様々な面において安全であり、リスクに対する配慮がなされていることを保証しているAIやその考え方を指します。企業側が多くのAIを開発する中で、自社がどのような基準でAIを作り、開発に挑んでいるのかを示したものが責任あるAIです。

AIは加速度的な進化を遂げており、そのAIに会社の命運を託すことがあります。AIが確かな性能を誇るからこそできることですが、一方でAIに倫理観や信頼などなければ、暴走してしまうのではないかという不安が出てきます。

そのため、企業側が責任あるAIに対する考えを表明することで、セキュリティ面やプライバシーの観点などに十分配慮したAIを作った上で企業経営に活用していることを伝えられます。Googleを始め、多くの企業が責任あるAIに対する考えを打ち出しており、AIを活用する企業の当然の姿と言えるでしょう。

責任あるAIの基本原則

責任あるAIに関してはいくつかの基本原則があります。ここではマイクロソフトが提唱する6つの基本原則についてご紹介します。

アカウンタビリティ

アカウンタビリティは説明責任という意味があり、AIをどのように作り、どのような形で実用に至ったかを説明する責務が企業にあることを示した言葉です。これらの情報はステークホルダーと呼ばれる人たちに開示され、様々な説明責任を果たしていきます。

いわば、AIの一挙手一投足について企業がどのように責任をとるつもりなのかを示したものと言えます。例えば、AIが非人道的な事柄を含めたものを出力し、世間が大騒ぎしたとします。悪いのはAIかもしれませんが、このAIは誰が作り、なぜこの事態に至ったのかを企業は説明しなければなりません。仮に実害が出れば、その責任をどこまで企業が負うのかも、ポイントになります。

過去にマイクロソフトではチャットボットが大問題を起こし、世界中で批判されています。こうした反省もマイクロソフトの中で共有され、説明責任が必要であることを示しているのです。

包括性

包括という言葉には包み込むという意味合いがあり、別の表現では多様性、多様な価値観などで表現しているケースがあります。つまり、色々な価値観を包み込んでいくのが包括性です。

AIが特定の人種を排除しない、様々な障害を持つ人を支援するために、企業側が様々な配慮を行っていくという宣言でもあります。テキストの読み上げや音声入力など、障害を抱える人でも利用できるような仕組みを作り上げようとするのが包括性です。これらに配慮することを踏まえてAIを開発するという姿勢が示されています。

信頼性と安全性

AIにとって大切なのは、設計されたものが想定通りに動くことです。そして、どのような状況であっても安全に動くことも求められます。世界中には悪意を持った人間が多くいますが、これらの悪意からAIを守っていくこと、その対策も企業側には求められるのです。

そのシステムをいかに構築しているのか、どんな対策をとっているのかを示した言葉が信頼性と安全性です。

公平性

どのような人種、性別、思想信条に対しても差別や不公平さを出さないよう、誰にとっても公平であることを示したのが公平性です。全ての人間を公平に扱うのが公平性の基本的なスタンスと言えます。

例えば、クレジットカードの審査をAIに託した場合に、奥さんの方がスコアはよかったのに夫の方が高めの利用限度額になっていたケースがありました。明らかに公平性に欠けるとして問題になりましたが、こうした公平性に対する視線は年々厳しくなっています。日本ではまだ公平性への厳しい視線はそこまで鋭くありませんが、今後注目すべきポイントです。

透明性

どのようにAIが結論を下したのか、そのプロセスをできる限り示せるようにすることを示したものが透明性です。先ほどのクレジットカードの件でも、男女差別ではないかと当然の指摘を受けた中、AIの責任であって差別の意図は一切なかったと企業側はアピールしています。

機械学習で近年問題になっているブラックボックス化は、なぜその結論に至ったのかが一切わからないので、修正のしようがなく、ある種説明責任を果たすのを阻害する要素となっています。近年ではホワイトボックス型を目指し、プロセスをしっかり示せるものを作ろうとする企業も多く、透明性に力を入れていることが目立ちます。

プライバシーとセキュリティ

プライバシーとセキュリティの問題は、AIを利用する中では重視されるべき要素であり、絶対に欠かせない部分と言えます。ChatGPTのように、それぞれの個人・企業が機密情報につながるようなことを入力しているケースがあります。この場合、入力した情報が蓄積され、第三者に情報が出力されていくことも考えられるのです。

個人情報の解析を行ったり、ネットの閲覧履歴からおすすめの商品や広告を示したりするなど、AIは便利に使われています。しかし、知らず知らずのうちにAIがパーソナルな部分にまで侵入し、勝手に利用されているという見方もできます。いかに個人を特定されないように活用していくかを示すことも企業側が果たすべき責任の1つと言えるでしょう。

責任あるAIの議論を呼ぶAIが起こした事件

責任あるAIを定義し、それぞれの企業が示すのには大きな理由があります。それはAIが事件を起こした際、訴訟に発展するのが明白だからです。これまでにAIがどんな事件を起こしたのかをご紹介します。

警察の誤認逮捕

アメリカでは顔認識システムを活用して犯人の特定を行っており、その際に誤認逮捕の事案が生じています。デトロイトで起きた事件では監視カメラで撮影された強盗犯の身柄を割り出す際に顔認識システムを活用したところ、1人の女性と一致したとして逮捕しました。

しかし、10年近く前の顔写真で照合していたほか、近々の顔写真があるにもかかわらず、新しいものでは照合せず、結果的に誤認逮捕となりました。

デトロイトの警察では過去にも顔認証システムを使って誤認逮捕を行い、いずれも黒人だったこともあって大きな問題になりました。公平性を始め、責任あるAIからはいささかかけ離れた状態だったと言えます。

AIとの会話で命を落とす事態

ベルギーでは、夫が対話型AIを相手に会話を行い、その結果、対話型AIが自分で命を絶つよう夫に仕向け、夫がその通りに自らの手でこの世を去っていったと、妻が被害を訴えるという出来事がありました。

夫は対話型AIと会話を重ねる中で、段々と対話型AIとコミュニケーションを重ねる時間が増えていきます。最終的に対話型AIから促されるような形で自ら命を絶ってしまったという話です。

この事件も影響し、EUではAI利用に対する規制法案が審議されて合意に至りました。責任あるAIのために、法律面で規制を設けていく形になったと言えます。日本ではまだこうした法律はありませんが、いずれEUで行われている議論がなされることでしょう。

責任あるAIと、AI倫理・AIガバナンス・説明可能なAIとの違い

ここからは責任あるAIと、AI倫理・AIガバナンス・説明可能なAIとの違いについてご紹介します。

AI倫理

AI倫理は、AIを活用して社会に対する利益をもたらすために、AIが問題を起こさないようにする指針です。バイアスによって差別につながることをなくす、非人道的なアクションを防ぐことが主な狙いです。人間の尊厳や民主主義の尊重、個人の自由、市民の権利などを重視したAIを作るためのフレームワークにもなります。

AIガバナンス

AIガバナンスは、AIを活用する際に社会のルールや制度を守り、規範を逸脱することがないよう管理や運用を行うことを指します。AIガバナンスは責任あるAIとAI倫理に関連しており、この2つがあって成り立っているものと言えます。いわばAIガバナンスを構成する2つの考え方です。

説明可能なAI

説明可能なAIは別名XAI、「Explainable AI」と呼ばれています。なぜその結果に至ったのか、そのプロセスや根拠を説明できるAIが「説明可能なAI」です。ディープラーニングで問題視されるブラックボックス化は、説明ができないことが要因となっています。

例えば画像認識において、何を見て画像を認識したかをヒートマップで示すGrad-CAMなども説明可能なAIの1つです。

責任あるAIを巡る日本での動き

EUを始め、アメリカなども責任あるAIを巡って様々な動きを見せています。2023年には群馬県でG7のAIを担当する大臣たちを集めた会議が行われ、責任あるAIを実現していくべくG7が連携することで合意しています。

日本では責任あるAIの開発や利用に向けて、専門家の支援センターを設置する動きもあり、本格的な導入に向けて政府も本腰を入れ始めている状況です。

サイバー攻撃も多様化しAIを狙い撃ちするようなケースも増え始めている中において、責任あるAIに向けた法規制などを早急に行う必要があります。日本は一歩遅れているような状況とも言えますが、法規制に向けた議論を急ピッチで行えば、他の国に追いつくことは十分に可能です。

責任あるAIに関するEUの動きは日本も無関係ではない

EUは先んじて責任あるAIに向けて、AIに関する規制法案が大筋で合意され、違反した企業には罰金が科せられることになっています。この法律では汎用AIへのセーフガードやソーシャルスコアリングなどの使用を制限したり禁止したりしています。

日本企業が注意すべきなのは、EUだけが範囲なのではなく日本がEUの国々にシステムを提供することになれば日本も対象になってしまう点です。世界全体の総売り上げの2~6%が罰金として徴収される可能性もあるので、細心の注意が求められます。

そのため、法規制に関係なく、企業側が責任あるAIのために自主的に気を付けていく必要があるほか、AIが適切なものかどうかを第三者に評価ないし検証してもらう必要があるでしょう。

まとめ

責任あるAIは今後避けては通れない問題であり、ただ単に開発すればいい時代ではなくなっています。自由に開発できず、制約が生まれると感じる人もいるでしょうが、より安心して利用してもらえる物を作ることはいつの時代も不変的なもので、金儲けに走り過ぎてルールを逸脱することへの危機感を持つことは珍しいことではありません。

むしろ法規制がなく、ルールがない状態でAIを稼働させることにより、自動運転などで事故を起こした際に誰が責任を取らないといけないのか、混乱する恐れもあります。安心してAIを活用するためにはいち早く責任あるAIの構築が求められるのです。

さらに、今注目を集める生成AIリスキリングの第一歩を。生成AIパスポートとは?

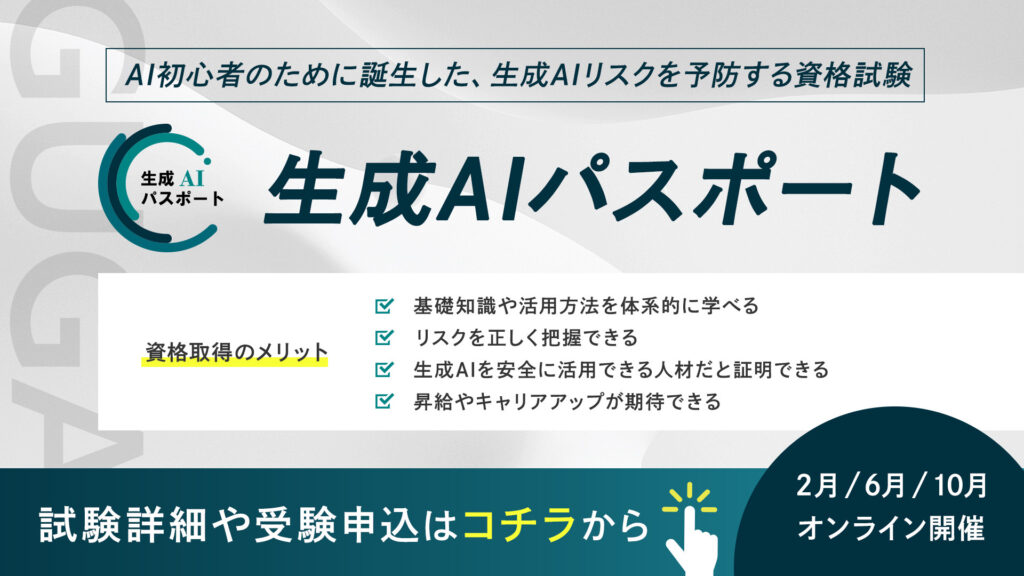

生成AIパスポートは、一般社団法人生成AI活用普及協会(GUGA)が提供する、AI初心者のために誕生した、生成AIリスクを予防する資格試験です。AIを活用したコンテンツ生成の具体的な方法や事例に加え、企業のコンプライアンスに関わる個人情報保護、著作権侵害、商用利用可否といった注意点などを学ぶことができます。

⽣成AIの台頭により、AIはエンジニアやデータサイエンティストといった技術職の方々だけではなく誰もがAIを使えるようになりました。今、私たちがインターネットを当たり前に活用していることと同様に、誰もが生成AIを当たり前に活用する未来が訪れるでしょう。

そのような社会では、採用や取引の場面で、生成AIを安全に活用できる企業・人材であることが選ばれる前提条件になり「生成AIレベルの証明」が求められることが予測できます。生成AIパスポート試験に合格すると、合格証書が発行されるため、自身が生成AIを安全に活用するためのリテラシーを有する人材であることを、客観的な評価として可視化することが可能です。

ぜひあなたも生成AIレベルを証明し「生成AI人材」に仲間入りしましょう!