DQN(Deep Q-Network)とは?機械学習としてのDQNの基礎意味や活用のコツを徹底解説!

INDEX

- DQN(Deep Q-Network)とは?

- DNNとQ学習の組み合わせ

- そもそもQ学習とは何か

- それぞれの持ち味を生かすやり方

- DQNの仕組みとは

- Qテーブルが畳み込みニューラルネットワークへ

- Experience Replay

- 2つのニューラルネットワーク

- 報酬の更新によって最適な行動を見つける

- DQNの学習プロセスについて

- まずは環境を用意する

- Q値の更新と予測を行う

- 逆伝播と数値の更新

- DQNを利用するメリット

- 答えがない状況でも対応できる

- 動作の制御に使える

- DQNを利用する際の注意点

- リソースの確保

- 正解を導き出せるとは限らない

- DQNの活用事例

- 自動運転

- おすすめ動画のレコメンド

- まとめ

- さらに、今注目を集める生成AIリスキリングの第一歩を。生成AIパスポートとは?

皆さんはDQN(Deep Q-Network)をご存じですか?DQNはディープラーニングを行っていく中で欠かせない手法の1つで、DNNとQ学習を組み合わせたものです。これがどんな意味を持つのか、気になる方も多いのではないでしょうか。

本記事ではDQN(Deep Q-Network)に着目し、どのような手法で学習していくのかなどをご紹介します。

DQN(Deep Q-Network)とは?

DQNとはどのようなものなのか、それぞれの意味や基本的な情報を解説していきます。

DNNとQ学習の組み合わせ

DQNはディープニューラルネットワークのDNNとQ学習を組み合わせたものです。DNNはディープラーニングの一種であり、コンピューターの中で人間の脳神経を再現し、人間のような思考で機械学習を行うことができます。

そもそもQ学習とは何か

Q学習はランダムにやらせてみて、ランダムの行動で得られた価値を入力していき、最終的に最も高い価値となった行動を見出して学ばしていく手法です。

Q学習では行動の価値について「Qテーブル」と呼ばれる場所で管理し、数値が更新されるたびにQテーブルに書き込んでいきます。

それぞれの持ち味を生かすやり方

DQNはDNNとQ学習のいいところを組み合わせ、それぞれの持ち味を生かしていくやり方です。実際にはDNNの中にQ学習を組み込んでいきます。Qテーブルだけだとたくさんの行動が求められる時にメモリが相当必要になる問題がありました。

DNNを用いることでメモリが大きくなりすぎないようにできるほか、様々な工夫を重ねられることで今までよりも学習の性能を高められます。

DQNの仕組みとは

ここからはDQNの仕組みをご紹介していきます。

Qテーブルが畳み込みニューラルネットワークへ

強化学習においてQ学習はQ関数、Qテーブルを用いてきましたが、DQNではこの関数を畳み込みニューラルネットワーク、いわゆるCNNへ置き換えていきます。Qテーブルのままだと行動数などが増えれば、それだけQテーブルで表しにくくなる問題を秘めていました。

その点、畳み込みニューラルネットワークであれば行動数が増えても畳み込みニューラルネットワークで凝縮できるため、学習の収束につなげることができます。畳み込み層といえば画像処理などに用いられますが、Q学習にも結び付けることが可能です。

Experience Replay

Experience Replayは、エージェントが経験しているサンプルに関してすべて記録して、Q学習で何回も学習させていくやり方です。過去の経験を利用するにはQ学習などを通じて積み重ねてきた情報をメモリに保存しておく必要があります。メモリに保存されたサンプルはランダムに用いられ、学習に活用されます。

2つのニューラルネットワーク

DQNでは2つのニューラルネットワークがあり、1つはQ値を出すために必要なQネットワーク、もう1つは学習の安定を確実なものにするために存在するターゲットネットワークと呼ばれるものです。

ターゲットネットワークはExperience Replayと行動選択それぞれで生じる誤差を求める際に用いられ、Q学習のデメリットである過大評価の抑制につなげられます。

一方のQネットワークはExperience Replayで学習を行い、そこで出された数値をターゲットネットワークに反映させる役目を担います。この反映のケースにもハードアップデート、ソフトアップデートの種類があります。

報酬の更新によって最適な行動を見つける

Q学習はゲームのやり方やルールを一切教えず、完全なランダムから1点でも多く得点を目指すために行われるものであり、報酬の更新によって最適な行動を見つけられます。このために2つのニューラルネットワークがあり、更新することで新たな方法が見つけられるのです。

これを繰り返していくことがDQNであり、強化学習にも効果的と言われる要因でもあります。

DQNの学習プロセスについて

DQNはどのようなプロセスで学習を進めていくのか、そのプロセスについて基本的な情報をまとめました。

まずは環境を用意する

DQNではまず環境の整備を行います。この場合の環境とはどんなことをやらせるのか、それに伴う報酬は何かなど、強化学習を行う方法や報酬を設定します。その上でこの時得られた報酬、経験などはメモリに保存され、ここでの数値がサンプルとして応用されることになります。

Q値の更新と予測を行う

Qネットワークで強化学習を行うと、様々なQ値が出てきます。このQ値が最も大きくなるであろう行動をとにかく選んでいくというのが一連の流れです。

その上で次にどんなQ値が出そうかの予測を行い、報酬の最大化につながる行動が出されます。あとは実際の数値と予測の誤差を計算した上で、次の学習へとつなげていきます。

逆伝播と数値の更新

実際に出た誤差は逆伝播によって出力層から入力層に伝わっていきます。この時にニューラルネットワークの重みづけを変えて、誤差を少しでもなくすための学習が行われます。

こうしたやり取りを繰り返す中でQ値はどんどん更新されるとともに、メモリからは古い経験は消えて新しい数値などが追加され、再び学習が行われます。この繰り返しによって学習の収束をチェックし最大化を図るのです。

DQNを利用するメリット

DQNを行うメリットにはどのようなものがあるのかをご紹介していきます。

答えがない状況でも対応できる

例えば将棋の世界ではプロ棋士の学習にAIが用いられており、強くなるスピードは以前よりも早いとされています。このAIの進化は以前まで教師あり学習によって、人間がある程度コントロールをしてきましたが、ディープラーニングの登場により、大きく変化しました。

将棋はいまだに必勝パターンが見つかっておらず、既に必勝パターンがあるオセロとは難易度が異なります。その中でそれぞれの駒の動かし方や勝ち負けのルールさえ教えて、あとはひたすら強化学習を行うことで答えがない状況でも対応できるようになります。

人間ではとても怖くて踏み出せない手順をAIは平気で示し、人間がこれまで持っていた感覚を打開しようとします。DQNはこれまでの常識を打ち壊し、新たな可能性を見出すことにも一役買っていると言えるでしょう。

動作の制御に使える

DQNを活用することで動作制御に使えるのも大きなメリットです。近年AIロボットなどAIを搭載したロボットなどが話題となっていますが、このロボットを動かすAIに活用できます。

場面場面での状況においてベストを求め続けられるため、ムダな動きをしないでコントロールが可能です。DQNを利用すれば臨機応変な対応を求められるのも魅力的です。

DQNを利用する際の注意点

DQNを利用する際にはいくつかの注意点もあります。ここでは注意点についてご紹介します。

リソースの確保

DQNの難点はリソースの確保です。ディープラーニングを行うにはたくさんのデータと計算に用いるリソースが欠かせません。大量のデータがないと新しく入ってきたデータに対応できなくなります。かといってたくさんのデータを処理するのはなかなか大変です。そのためにリソースの確保が求められます。

リソースの確保ではニューラルネットワークを大規模にする必要があるほか、大規模にする分、計算能力なども問われます。このあたりの準備を周到に行わないとうまくいかないのです。

正解を導き出せるとは限らない

報酬の最大化のためにあるのが強化学習ですが、強化学習の結果、すべてが正しい結果になるとは限らないのが実情です。むしろ不正解の可能性まで出てくるため、過度に信じてはいけないケースも出てくる場合があります。

またコンピューターの中ではベストな答えでも、それを現実世界で完璧に再現できるとは限らないケースもあり、そのあたりも厄介と言えます。

DQNの活用事例

最後にDQNの活用事例についてご紹介します。

自動運転

DQNで期待されるのは自動運転です。自動運転には相当な技術力が求められます。現状では運転手のアシストを行うAIなどが出ており、完全な自動運転まではいかないにしても、危険をできる限り回避するような技術が出ています。

その中で物体の認識など様々な技術をDQNによって高めていき、完全に手を離した状態でも運転できるようにすることができる時代に近づこうとしています。

おすすめ動画のレコメンド

YouTubeのおすすめ動画などは、これまで見た動画やユーザーの興味関心、もしくは不快に思ったコンテンツの報告などからおすすめ動画がピックアップされます。明らかに趣味ではない動画が出てくる可能性は低い一方で、直前に見た動画に似たものが出てくることもあります。

おすすめ動画のレコメンドに限らず、通販サイトでのおすすめ商品もおすすめ動画のレコメンドと同じような形で作られています。

まとめ

DQNは強化学習をより深く行うのに適した方法であり、これからのAIの技術を高めるのに大いに役立つことは間違いありません。一方で誰でも簡単に始められるとは言い難いほか、これからDQNを学びたい人にとって、初心者から始めるための教材がまだまだ不足しています。

DQNは一定のリテラシーや知識がないと始めにくいため、いかに若い段階からリテラシーを身につけさせ、知識をつけさせるかも大事な部分となるかもしれません。強化学習は間違いなくビジネスで用いられる時代が来ます。本格的にその時代が到来する前に、スキルを身につけておけるかも大事でしょう。

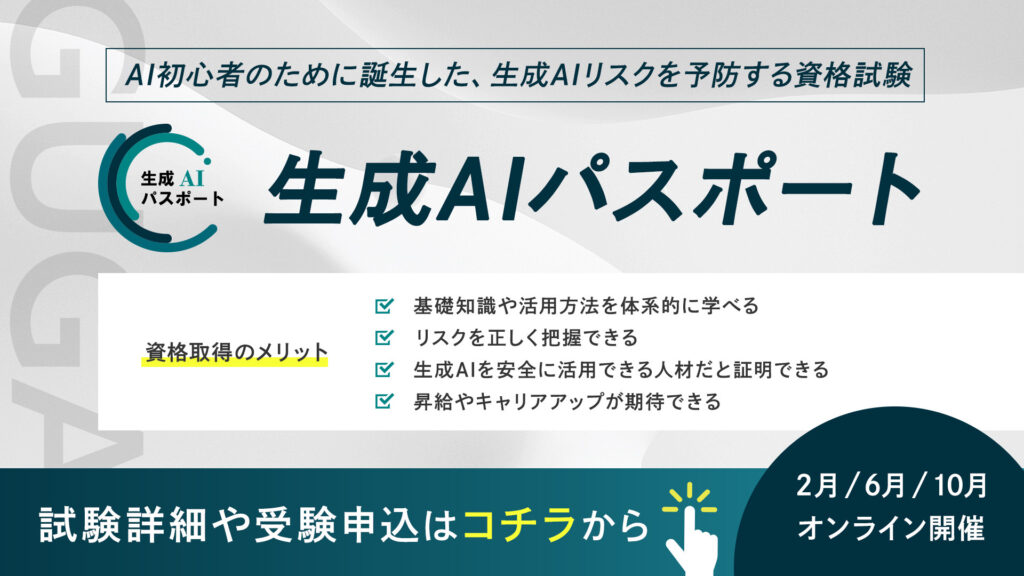

さらに、今注目を集める生成AIリスキリングの第一歩を。生成AIパスポートとは?

生成AIパスポートは、一般社団法人生成AI活用普及協会(GUGA)が提供する、AI初心者のために誕生した、生成AIリスクを予防する資格試験です。AIを活用したコンテンツ生成の具体的な方法や事例に加え、企業のコンプライアンスに関わる個人情報保護、著作権侵害、商用利用可否といった注意点などを学ぶことができます。

⽣成AIの台頭により、AIはエンジニアやデータサイエンティストといった技術職の方々だけではなく誰もがAIを使えるようになりました。今、私たちがインターネットを当たり前に活用していることと同様に、誰もが生成AIを当たり前に活用する未来が訪れるでしょう。

そのような社会では、採用や取引の場面で、生成AIを安全に活用できる企業・人材であることが選ばれる前提条件になり「生成AIレベルの証明」が求められることが予測できます。生成AIパスポート試験に合格すると、合格証書が発行されるため、自身が生成AIを安全に活用するためのリテラシーを有する人材であることを、客観的な評価として可視化することが可能です。

ぜひあなたも生成AIレベルを証明し「生成AI人材」に仲間入りしましょう!