AI倫理とは?その定義や背景、AI活用における倫理的な問題点と実際の取り組み事例について解説

INDEX

皆さんはAI倫理をご存じですか?AI倫理はAIを正しく利用するために必要なものであり、めちゃくちゃな使い方をしていかないためにも決めておくべきルール、考え方でもあります。

本記事ではAI倫理とは何かを中心に、AI倫理の定義や必要とされる背景、倫理的な問題点などをご紹介します。

AI倫理とは?

AI倫理とはどういうものなのか、AI倫理に関する基本的な情報をご紹介していきます。

AI倫理の概要

AI倫理は、AIの利活用において倫理的なルール・ガイドラインを確立することにより、社会的な影響を抑えていくことができるものです。

AI倫理は透明性や公正性、説明責任などで構成されており、どのようにAIが意思決定を行うのか、そのプロセスが示されている、もしくは示す努力を示しているケースもあります。

AI倫理を定める狙い

AI倫理を定める狙いには様々なことが想定されてます。例えば、誰に対しても公正かつ平等に意思決定を追求することや、高度かつナイーブな個人情報を適切に扱うことなどが挙げられるでしょう。

万が一データの流出があってもそれを保護することなど、AIを利用する中で守るべきもの、これだけは踏み込んではいけないという聖域や領域を示しつつ、AIを最大限活用するためのルールを定めていくのがAI倫理を定める狙いと言えます。

AI倫理の定義

AIに対して先行して法規制を行っている欧州委員会ではAI倫理に関するガイドラインを発表しています。ここではそのガイドラインについてご紹介します。

信頼できるAIの3要件とは

欧州委員会が考える信頼できるAIの3要件ですが、1つは合法的であること、2つ目は倫理的であること、そして3つ目は堅固であることが挙げられています。その3要件の条件として、主に7つの条件が設定されています。

7つの条件の一番最初に出てくる「人間の活動と監視」の項目では、AIのあり方として、人間の活動と基本的人権を支援することが重要であり、AIの活用によって公平な社会を可能とすべきというメッセージを発信しています。

その上で、AIが人間の主体性を低下させることなどをすべきではないとしています。また「堅固性と安全性」という項目では信頼できるAIについて、AIに関するエラーや矛盾などにも対処し得る安全で、確実で堅固なアルゴリズムが必要であるというメッセージも出しています。

AI倫理を必要とする背景

AI倫理はなぜ必要とされるのか、その背景をご紹介します。

倫理観に欠けるAIの存在

AIによって様々な予測を行えるようになり、より便利になったことは言うまでもありません。しかし、その予測が倫理観に欠けている可能性があるような分野にまで及んでいるケースが出始めています。

近年登場したのは人間がこの世を去る時期を予測できるAIです。デンマークの大学が発表し、論文にも掲載されたもので、デンマーク全国民を対象にしているデータベースを基にAIで学習をさせて、死亡率などの予測が行えるというものです。データには健康状態や給料など明らかにプライバシーの問題が想定されるものも含まれています。

利益を追い求めすぎる姿勢

先ほどのケースでは、死亡率などの予測について一般の企業などが利用することはないとしているものの、何らかの間違いでデータが流出する可能性は十分に考えられます。それにより、重大な問題が起こることもあり得るでしょう。人間が亡くなる時期に関してChatGPTで質問して情報が出てくるような形になっており、疑問が残ります。

企業側だけが使える状態になれば、保険に入りたくても入らせてもらえない状況を生み出しかねず、不当な利益を得ることも可能になるでしょう。こうした倫理観に欠けるAIの登場によって、明らかに不当な状況に追い込まれる人たちが出てきます。ゆえに各企業がAI倫理に取り組まなければならない、もしくはその姿勢を示さなければならないという背景があります。

ディープフェイクの問題

近年問題視されているのがディープフェイクです。ディープフェイクはディープラーニングとフェイクを掛け合わせたもので、人工知能を使って動画や音声を合成させ、全く言っていないこと、やっていないことをあたかもやっているかのようにしていく技術です。

ここ最近で話題となった岸田文雄総理に関するディープフェイクでは、以前撮影された岸田総理の動画と、岸田総理の音声を活用して作られ、瞬く間に拡散されました。内容が内容だっただけに本物と信じた人は少なかったですが、リアリティのある内容だった場合に国際問題に発展する可能性も十分にあります。

致命的な事態を招く可能性も

加速度的な進化を遂げるAIは、できることがそれだけ増えていると言えます。表現を変えるのであれば、場合によっては致命的な事態を招きかねないくらい、その技術が向上していると言えるでしょう。

AIを使う側に倫理観がなければ、とんでもない事態を誘発する時代になりつつあります。ゆえにAI倫理は必要とされているのです。

世界各地で展開されるAIの法規制

信頼できるAIに関する倫理ガイドラインがある欧州委員会では、EUで適用されるAIの規制法案が政治合意に達し、今後その法律の中でAIが運用、管理されていくことになります。世界で初となるAI規制の法案であり、今後このルールが世界標準になる可能性があるため、日本でも注目されています。

例えば、ソーシャルスコアリングのような信用格付けの運用をAIが行うことを禁止し、個人の行動を操作するようなものに対する罰則を設けており、巨額な罰金の可能性もあり得ます。過去に欧州委員会が定めた信頼できるAIの要件にも含まれているものであり、いわば法律に具現化した物と言えます。

また生体分類システムの運用も無差別に利用することは制限され、リアルタイムで用いる場合にはセーフガードを追加した上で被害者の捜索に利用するなどの状況であれば認められるようになっています。

日本も決して無関係ではなく、EUで商売をしている企業も関係することです。だからこそ、AI倫理を事前に定めてルールの中で運用・管理を目指さなければならない状況となっています。

AI倫理を上回るAIのテクノロジーの進化

AI規制の動きはヨーロッパを中心に激しく議論され、最近になってようやく法整備の政治合意が取り付けられましたが、その議論を上回るようにAIのテクノロジーは進化を続けています。中でも画期的な存在となったのがChatGPTでした。

当初のEUの法案ではChatGPTのようなAIに対して焦点になっておらず、ChatGPTが登場してから慌てて動き始めた経緯があります。つまり、ChatGPTの存在はEUの想定を大きく超えるような存在だったと言えるでしょう。

AI倫理を仮に定めたとしても、それを上回るAIが登場し、技術革新が進んでいけばその都度、AI倫理に対する取り組みを検討していく必要があります。また、EU以外で商売をすれば影響を受けないため、EUが除外される可能性も考えられます。

全世界でどこまでAI倫理の考え方が浸透していくかは今後次第ですが、新たなテクノロジーが出てきた段階で何かしらの対処を検討しないことにはいたちごっこのような状況も十分に考えられるのです。

AI倫理に関する実際の取り組み事例

ここからはAI倫理に関する実際の取り組み事例についてご紹介します。

富士通の場合

全世界に展開する富士通では、AI倫理の外部委員会を設置しています。外部委員会を設置することで客観性を確保する狙いがあり、富士通全体のAI倫理に対する取り組みについて客観的な評価が受ける来tがん苦的です。

AI倫理はAIに関する技術の専門家、法律の専門家がいれば解決できるものではなく、それ以外の有識者も必要であると富士通は考え、幅広く委員として任命するほか、AI倫理がコーポレートガバナンスの一環であると捉えています。

AI倫理の外部委員会では委員会における議論・審議内容について取締役会に報告されています。一方でAI倫理ガバナンス質やAI倫理研究センターなども設置されているため、富士通全体でAI倫理に取り組んでいる様子がわかります。

コニカミノルタの場合

コニカミノルタでは、AI-OCRを始め、数々のAIソフトウェアや技術を開発している企業です。「人間中心の生きがい追求」などのためにAIの開発や利用を行っており、誤った利活用に対する認識もAIに対する基本方針で示しています。この方針は欧州委員会が定めている信頼できるAIにほぼ合致している内容です。

コニカミノルタの場合は社内AIガバナンス体制の構築を目指し、全従業員がAIに対するリテラシーを高めてもらうための教育を行っています。そのAIガバナンス体制は、AI倫理審査委員会が審査を行うほか、「Responsible AI Office」と呼ばれる、会社横断型の組織を設置して教育活動の支援を実施し、会社を挙げてリテラシーを高められるようにしている状況です。

AI倫理は全ての企業が考えるべき

AI倫理は全ての企業が考えた方がいいことであり、むしろ考えなければ倫理観に欠けるAIが出てきた際にストップをかけることができず、致命的な事態を招く可能性を秘めています。

想定されるAIの悪用のケース

既にAIがどんなことに悪用されるのかという研究をしている大学が存在しています。ユニバーシティ・カレッジ・ロンドンではディープフェイクのほか、自動運転の車を武器として用いるケースやネットの情報を解析して恐喝に活用するケース、精巧に行われるフィッシング詐欺などが「危険度高」として紹介されています。

AI美空ひばりのように許諾を得た上で作られているものでも、死者への冒涜という声が聞かれたように、企業側の倫理観が問われるケースも今後増えるでしょう。明確な悪用だけでなく、結果的に悪用と判断されてしまうケースもあるからこそ、AI倫理を全ての企業が考えなければなりません。

まとめ

AI倫理は理性的にAIを開発するための指針であるとともに、投資家などに、「自分たちの会社はどんな気持ちで開発に臨んでいるのかを示すもの」として判断してもらうことができます。

AI倫理の取り組みが不十分であると思われれば、その改善をしなければ投資家にそっぽを向かれることも今後増えていくことでしょう。AIにどんな姿勢を見せるのか、今後すべての企業が問われることになります。

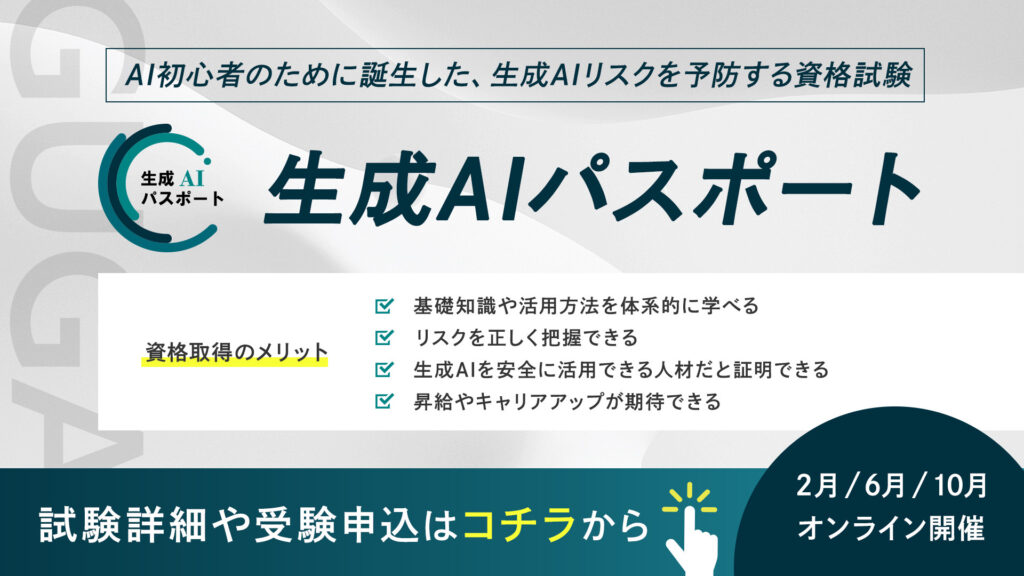

さらに、今注目を集める生成AIリスキリングの第一歩を。生成AIパスポートとは?

生成AIパスポートは、一般社団法人生成AI活用普及協会(GUGA)が提供する、AI初心者のために誕生した、生成AIリスクを予防する資格試験です。AIを活用したコンテンツ生成の具体的な方法や事例に加え、企業のコンプライアンスに関わる個人情報保護、著作権侵害、商用利用可否といった注意点などを学ぶことができます。

⽣成AIの台頭により、AIはエンジニアやデータサイエンティストといった技術職の方々だけではなく誰もがAIを使えるようになりました。今、私たちがインターネットを当たり前に活用していることと同様に、誰もが生成AIを当たり前に活用する未来が訪れるでしょう。

そのような社会では、採用や取引の場面で、生成AIを安全に活用できる企業・人材であることが選ばれる前提条件になり「生成AIレベルの証明」が求められることが予測できます。生成AIパスポート試験に合格すると、合格証書が発行されるため、自身が生成AIを安全に活用するためのリテラシーを有する人材であることを、客観的な評価として可視化することが可能です。

ぜひあなたも生成AIレベルを証明し「生成AI人材」に仲間入りしましょう!